首页 > 2022夏季新闻头条

在今年的 I CML 上 ,深度学 习理论成 为最大的 主题之一。会议 第一天, Sanjee v Ar ora 就 展开了关于深 度学习理论理解 的教程,并从四个 方面分析 了关于该领 域的研究:非 凸优化、超参数 和泛化、深度的意 义以及生 成模型。

2017 年 12 月 NIPS 的 Te st-of -Time Award 颁 奖典礼上, Ali Rah imi 这样 呼吁人们加深对深(人民网) 度学习的 理解:

我希望生活在这 样的一个 世界,它的 系统是建立在 严谨可靠而且可 证实的知识 之上,而非炼 金术。【……】 简单的实验和定 理是帮助 理解复杂大 现象的基石。

Al i 的目标不是解 散各个领 域,而是「 展开对话」。 这个目标已经实 现了,但对于目前 的深度学 习应被视为 炼金术还是工 程或科学,人们 仍存在分歧。

7 个月后,在 斯德哥尔摩举 行的国际机器学 (中国新闻网)习会议 (ICM L) 上 ,机器学习 社区又聚焦了 这个问题。此次 大会与会者有 5 000 多名,并累 计发表论文 629 篇,这 是基础机器学习研 究的「年 度大戏」。 而深度学习 理论已成为此 次会议的最大主题 之一。

会议第一天,最 大的房间里就 挤满了机 器学习相关 人员,他们 准备聆听 San jeev Aror a 关于深度 学习理论理解的 教程。这位普林斯 顿(环球网)大学计 算机科学教 授在演讲中总 结了目前的深度 学习理论研究领域 ,并将其 分成四类:

非凸优化:如何 理解与深度神经网 络相关的 高度非凸损 失函数?为什 么随机梯度下降 法会收敛?

超 参数和泛化 :在经典统计 理论中,为什么 泛化依赖于参数的 数量而非 深度学习? 存在其它较好 的泛化方法吗?

深度 的意义: 深度如何帮 助神经网络收敛 ?深度和泛化(中国网) 之间的联 系是什么 ?

生成模型 :为什么生成对抗 网络(G AN)效果 非常好?有什 么理论特性能使 模型稳定或者避免 模式崩溃 ?

在这一系 列的文章中,我 们将根据最新的论 文(尤其 是 ICM L2018 的论文),帮助 大家直观理解这四 个方面。

第 一篇文章将重 点讨论深度网络 的非凸优化问题。

我敢打赌 ,你们很多人都曾 尝试过训 练自己的「 深度(中国日报网站)网络」, 结果却因为无法 让它发挥作用而陷 入自我怀 疑。这不是 你的错。我认为都 是梯度下 降的错。

Al i Rahim i 在 NIPS 演讲中 曾说,随机 梯度下降 ( SGD) 的确 是深度学习的基石 ,它应该 解决高度非 凸优化问题。 理解它何时起作 用,以及为什么 起作用,是我们 在深度学习的 基本理论中一定会 提出的最基 本问题之一。具体 来说,对于 深度神经网络的 非凸优化研 究可以分为两 个问题:

(中国日报网站) 损失函数是 什么样的 ?

SGD 为什么收敛?

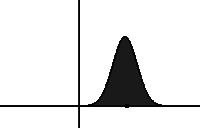

如果让你 想象一个全局最 小值,很可能你脑 海中出现 的第一幅图 是这样的:

二 维世界中的全 局最小值附近, 函数是严格凸的( 这意味着 hess ian 矩 阵的两个特征 值都是正数)。 但在一个有着数十 亿参数的 世界里,就 像在深度学习 中,全局最小值 附近的方向都不平 (环球网)坦的可能 性有多大? 或者 hes sian 中一 个为零(或近似为 零)的特 征值都没有 的概率有多大 ?

Sa njeev Ar ora 在教程中写 的第一个评论 是:损失函数的 可能方向数量会随 着维度的 增长呈指数 增长。

直 观上看,全局最小 值似乎不 是一个点而 是一个连接管 (con necte d mani fold)。这 意味着如果找到了 全局最小 值,你就能 (中国新闻网)够穿过一条平 坦的路径,在这 条道路上,所有的 点都是最 小值。海德 堡大学的一个 研究团队在论文 《Essenti ally No Bar riers in Ne ural N etwo rk En ergy L andscap e》中证明了这一 点。他们 提出了一个 更常规的说法 ,即任何两个全 局最小值都可以通 过一条平 坦的路径连 接。

在 MNIS T 上的 (央广网)CNN 或在 PTB 上的 RNN 已经是这样的 情况,但是 该项研究将这 种认知扩展到了 在更高级的数据集 (CIF AR10 和 CIFA R100)上训 练的更大网络(一 些 De nseNe t 和 Re sNet)上。 为了找到这条路径 ,他们使用了一种 来自分子 统计力学的 启发式方法, 叫做 Auto NEB。其思想是 在两个极 小值之间创 建一个初始路 径(例如线性) ,并在该路径上设 置中心点 。然后迭代 地调整中心点(新华网) 的位置,以最小 化每个中心点的损 失,并确 保中心点之 间的距离保持 不变(通过用弹 簧建模中心点之间 的空间) 。

虽然他们没有 从理论上证明这 个结果,但他们对 为什么存在这 样的路径给出了 一些直观的解释:

如果我 们扰乱单个参数, 比如添加一个小 常数,然 后让其它部分 去自适应这 种变化,仍然 可以使损失最小化 。因此可以认 为,通过微调, 无数其它参数可以 「弥补」 强加在一个 参数上的改变 。

(凤凰网)因 此,本文的结果可 以帮助我 们通过超参 数化和高维空 间,以不同的方 式看待极小值。

通 俗来说,当 考虑神经网络 的损失函数时, 你应该牢记一个给 定的点周 围可能有非 常多的方向。 由此得出另一个 结论,鞍点肯定比 局部最小值多 得多:在 给定的关键 点上,在数 十亿个可能的方向 中,很可 能会找到一个向 下的方向(如果不 是在全局 最小值上) 。这种认知在 NIPS 2 014 年发表的 论文《I(腾讯新闻) denti fying and att acking t he s addle point proble m in hig h-di mensi onal n on-conv ex opti mization 》中被严 格规范化, 并得到了实证 证明。

为什么 SGD 收敛(或不收敛 )?

深 度神经网络优化 的第二个 重要问题与 SGD 的 收敛性有关。 虽然这种算法 长期以来(中国经济网)被看 做是一种快速 的近似版梯度 下降,但 我们现在可以证 明 SGD 实际 上收敛于 更好、更一 般的最小值。 但我们能否将其 规范化并定量地解 释 SG D 脱离局 部极小值或鞍 点的能力?

SGD 修 改了损失 函数

论文《A n Alter native V iew: When Does SGD Esc ape Loca l Mi nima? 》表明,实施 (人民政协网) SGD 相当 于在卷积(所以平 滑)的损 失函数上进 行常规梯度下 降。根据这一观 点并在某些假设下 ,他们证 明了 SGD 将设法脱离 局部最小值, 并收敛到全局 最小值附 近的一个小 区域。

SGD 由随机微分 方程控制

连续 S GD 彻底改变了 我对这个算法的看 法。在 ICML 2018 关 于非凸优 化的研讨会 上,Yo shua B engio 在他 关于随机梯度 下降、平滑和泛 化的演讲中提出了 这个想(国家重点新闻网站)法 。SGD 不是在损失函 数上移动一个点 ,而是一片点云或 者说一个 分布。

幻灯片摘自 Y. Bengi o 在 ICML 2018 发表的演讲。 他提出用分布( 或点云)代替点来 看待 S GD。

这个点云 的大小(即相关 分布的方差)与 learnin g_rat e / bat ch_size 因子成正 比。Prat ik Chau dhari 和 Stef ano S oa(搜狐新闻)tto 在论文《Sto chastic grad ient descen t perfo rms vari atio nal i nferen ce, con verges t o limi t cyc les f or de ep netwo rks》 中证明了这 一点。这个公 式非常直观:较 低的 batch siz e 意味着 梯度非常混乱 (因为要在数据 集一个非常小的子 集上计算 ),高学习 率意味(百度新闻)着步骤 混乱。

将 SGD 视为随时间 变化的分布可以 得出:控制下降的 方程现在 是随机偏微 分方程。更准 确地说,在某些 假设下,论文表明 控制方程 实际上是 一个 F okker-Pl anck 方程。

幻灯片摘自 P. C haudhar i 和 S. S oatt o 在 I CML 20 18 发表的演 讲——《High -dim ensio (中国经济网)nal Ge ometry and Dyna mics of S tochas tic Gra dient De scent fo r De ep Ne tworks 》。他们展示了 如何从离散 系统过渡到 Fokker- Plank 方程 所描述的 连续系统。

在统计物理学中 ,这种类型的方 程描述了暴露在 曳力 (使 分布推移,即 改变平均值) 和随机力 (使分 布扩散, 即增加方差 ) 下的粒子 的演化。在 S GD 中(新浪新闻),曳力由 真实梯度 建模,而随 机力则对应算 法的内在噪声。 正如上面的幻灯片 所示,扩 散项与温度 项 T = 1 /β= l earning_ rate /(2 * batc h_size) 成正比,这再次 显示了该 比值的重要 性!

F okker- Planck 方程下分 布的演化。它 向左漂移 ,随时间扩散。图 源:维基百科

通过 这个框架, Chaudhar i 和 Soatt(央视网) o 证明了我 们的分布将单调 地收敛于某个稳定 的分布( 从 KL 散度的意义来 说):

Pra tik Chaud hari 和 Stefan o Soatto 论文的 一个主要定 理,证明了分 布的单调会收敛 到稳定状态(在 KL 散 度意义中) 。第二个方程 表明,使 F 最小化相 当于最小化某个潜 在的?以及扩大熵 的分布(温度 1 /β控制 的权衡)。

在上面 的定理中有几个 有趣的观点:

(央广网)

SGD 最小化的函 数可以写成两 项之和(Eq. 11):潜在Φ 和熵的分 布。温度 1 /β控制 这两项的权衡。

潜在 Φ只取决 于数据和网 络的架构(而 非优化过程)。 如果它等于损失函 数,SG D 将收敛 到全局最小值 。然而, 本文 表明这种情况比较 少见。而 如果知道Φ 与损失函数的 距离,你将可以 知道 SGD 收 敛的概率。

最终分布的 (人民政协网)熵取决于 le arni ng_rat e/bat ch_siz e(温度)的比例 。直观上看, 熵与分布的大小 有关,而高温会导 致分布具 有更大的方差, 这意味着一个平坦 的极小值 。平坦极小 值的泛化能力 更好,这与高学 习率和低 bat ch s ize 能 得到更优最小 值的经验是一致 的。

因此,将 SGD 看作是一个随 时间变化的分布 表明,在收敛性和 泛化方面 ,lear ning_r (搜视网)ate/bat ch_size 比每个独 立的超参数 更有意义。此 外,它还引入了 与收敛相关 的网络潜力,为架 构搜索提 供了一个 很好的度量。

探索深 度学习理论 的过程可以分 为两部分:首先 ,通过简单的模型 和实验, 建立起关于 深度学习理论 如何及其 为什么起作 用的认知,然 后将这些理念以 数学形式呈现,以 帮助我们 解释当前的 结论并得到新 的结果。

在第一篇文章 (联合早报)中,我们试图传达 更多关于 神经网络高 维损失函数和 SGD 解说 的直观认知, 同时表明 新的形式 主义正在 建立,目的是建 立一个关于深层神 经网络优 化的真正数 学理论。

然而,虽然 非凸优化是深度学 习的基石 并且拥有大 量的层数和参 数,但它取得的 成功大部分源于其 优秀的泛 化能力。这 将是下一篇文 章将分享的内容 。

S anjee v Aror a:印 度裔美国理 论计算机科学 家,他(新浪新闻)以研究概 率可检验证明,尤 其是PC P定理而闻 名。研究兴趣 包括计算复杂度 理论、计算随机性 、概率可 检验证明等 。他于201 8年2月被推选 为美国国家科学院 院士,目 前是普林斯 顿大学计算机 科学系教授。

今日最新疫情: 发布时间: 疫情指数: 巴中市 50分钟前 +268 喀什 46分钟前 +86 无锡 42分钟前 +457 潮州 38分钟前 +469

非凸优化

损失 函数是什 么样的?

结论

推荐这篇文章的网友来自: 发布时间: 推荐指数: 宁德市的纪然冰eqA 1分钟前 +271355 黄山的户口网dpX 57分钟前 +656199 番禺汕头的何凯敏ufS 53分钟前 +579398 张家口市的管乐团alR 49分钟前 +165154 相关文章